ChatGPT i inne metody NLP zapowiadają nowe czasy. Trzymajcie się, nadchodzi rewolucja!

Na początku spróbujmy odpowiedzieć sobie na pytanie – czym właściwie jest ten niezwykle popularny ostatnio chatGPT? Najprościej ujmując, jest to bot wykorzystujący model języka naturalnego GPT-3 (niedawno pojawił się już GPT-4) opracowany przez firmę OpenAI. Narzędzie to służy do generowania odpowiedzi w języku naturalnym na wszelkie pytania zadane w tym języku. Chat „z gracją” formułuje pełne zdania, płynnie i spójnie odpowiada, nie gubiąc przy tym kontekstu – oczywiście do pewnego momentu. Model ten został opracowany na podstawie dużych zbiorów danych liczonych w dziesiątkach TB (głównie treści internetowych), ale też z użyciem olbrzymich mocy obliczeniowych, czyli tysięcy kart graficznych.

Jaka technologia stoi za chatGPT?

Cały mechanizm bazuje na głębokich sieciach neuronowych (ang. deep learning), zastosowanych do przetwarzania języka naturalnego. Wykorzystano neuronowy model języka naturalnego GPT3 (niedawno pojawił się jego następca GPT4) wytrenowany na olbrzymich korpusach w sposób w pełni nienadzorowany, a następnie go dostrojono do konkretnego zadania. W tym przypadku zadania konwersacji, czyli „przyuczono go” do efektywnego odpowiadania na pytania. Pamiętajmy, że wielotorowe uczenie tego modelu dotykało wielu aspektów uczenia – od nienadzorowanego, po nadzorowane, ale też uczenia ze wzmocnieniem, które moim zdaniem było game changerem tego rozwiązania.

ChatGPT został uruchomiony jako prototyp 30 listopada 2022 i szybko pobudził wyobraźnię. Jesteśmy już w momencie otwierania nowego rozdziału wkraczania AI z laboratoriów do życia codziennego. Możliwości wykorzystania tego rozwiązania są szerokie: od diagnozowania chorób, odpowiadania na pytania z wiedzy o historii ludzkości, wsparcia w zadaniach programistycznych czy nawet pisania esejów/ rozprawek. Reasumując, tego rodzaju bot potrafi nas zachwycić szerokim zakresem zadań, jakie potrafi wykonać.

Milion użytkowników w ciągu zaledwie 5 dni

ChatGPT zyskał ponad milion użytkowników w ciągu zaledwie 5 dni (dla porównania Netflixowi zajęło to 41 miesięcy, Facebookowi – 10 miesięcy, a Instagramowi – 2,5 miesiąca). Wszystko to potwierdza, iż ludzkość jest zafascynowana tego rodzaju rozwiązaniami, wręcz pragnie obecności AI w swoim codziennym życiu.

ChatGPT potrzebował tylko 5 dni, aby zyskać milion użytkowników

ChatGPT stał się też nadzwyczajnym propagatorem NLP (ang. Natural Language Processing), czyli dziedziny odpowiedzialnej za szeroki zakres metod przetwarzania języka naturalnego. Można to uznać za swego rodzaju fenomen. Przetwarzanie języka naturalnego to gałąź sztucznej inteligencji, która umożliwia komputerom rozumienie języka ludzkiego oraz generowanie wypowiedzi w jęz. naturalnym. W OPI jesteśmy propagatorami rozwiązań NLP dla języka polskiego, a w szczególności neuronowych modeli języka polskiego. Nasze rozwiązania są jednymi z nielicznych dostępnych bezpłatnie dla szerokiego grona odbiorców. Każdy może je pobrać z naszej strony internetowej. Dodatkowo przygotowujemy nowoczesne narzędzia z wykorzystaniem tych metod i modeli m.in. dla Urzędu Ochrony Konkurencji i Konsumentów.

Szerokie wykorzystanie metod i modeli NLP

Większość konsumentów prawdopodobnie korzystała z NLP jeszcze przed chatGPT, nie zdając sobie z tego sprawy. Jednym z pierwszych historycznie zastosowań metod NLP było filtrowanie spamu mailowego, automatyczne tłumaczenie tekstu, podsumowywanie dokumentów, czy analiza sentymentu w opiniach produktów. Następnie wraz z rozwojem internetu i social mediów wielkie koncerny jak np. Google, Meta, czy Amazon zainwestowały olbrzymie środki w rozwój metod NLP. Robiły to, aby poprawić swoje rozwiązania bazujące na olbrzymich danych nieustrukturyzowanych, jak wpisy w języku naturalnym czy strony internetowe. My wszyscy byliśmy bardzo często konsumentami tych rozwiązań NLP, ale bez pełnej świadomości o tym. Teraz nastąpiło szersze uświadomienie społeczeństwom, że technologie NLP (w tym rozbudowane narzędzia dialogowe) mogą zmieniać całe procesy interakcji człowiek-komputer, w tym wpływają także na szereg branż gospodarki. Nawet najbardziej konserwatywne sektory będą zmuszone do rozważenia implementacji NLP do swoich procesów interakcji z klientami.

NLP jako data mining na danych tekstowych

W 2009 roku, zaczynając studia doktoranckie na Politechnice Warszawskiej, wybrałem jako obszar zainteresowań właśnie NLP. Doskonale pamiętam, co mówiono wtedy o tej technologii. Uważano NLP za rodzaj data mining na danych tekstowych. Cały mechanizm polegał na przekształceniu danych tekstowych do postaci macierzy TDM (ang. Term-Document Matrix), gdzie wiersze reprezentują słowa, kolumny dokumenty, a komórki tej macierze zawierają informacje o wystąpieniu i wadze określonego słowa w danym dokumencie. Mając taką macierz (najczęściej pełną zer), stosowaliśmy od dekad znane metody data miningu, m.in. wykrywanie wzorców, maszyny wektorów nośnych czy metody probabilistyczne, takie jak np. sieci Bayesowskie i modele Markowa. Pamiętam, że wtedy w środowisku AI byliśmy traktowani jako pewna specyficzna nisza, a nie główny strumień rozwoju sztucznej inteligencji. Potem nastąpiło kilka kluczowych „wstrząsów”, związanych z sieciami neuronowymi, które zmieniły sposób rozwoju NLP. Cztery, najważniejsze „wstrząsy” to: powrót sieci neuronowych pod postacią word2veca, głębokie sieci rekurencyjne jak np. LSTM, powstanie sieci typu Transformer oraz modele generatywne, np. GPT, BART, czy T5. To wszystko otworzyło nowe możliwości, wręcz niewyobrażalne w 2009 r.

Sieci typu Transformer z ponad 90% efektywnością

W 2021 r. razem ze Sławkiem Dadasem z OPI braliśmy udział w konkursie na opracowanie metod AI z wykorzystaniem NLP w domenie prawnej. UOKiK zorganizował konkurs, którego celem było przygotowanie narzędzia AI, które mogłoby w znaczący sposób przyczynić się do zwiększenia efektywności i skuteczności wykrywania potencjalnych naruszeń praw konsumentów. Celem przedsięwzięcia było przyspieszenie procesu analizy dużej ilości danych przetwarzanych przez urząd, a także zautomatyzowanie czynności, które mogą być wykonywane przy wykorzystaniu sztucznej inteligencji. Tym samym dane narzędzie miało odciążyć pracowników UOKiK. W ramach konkursu jedno z zadań dotyczyło opracowania modelu binarnej klasyfikacji postanowień umownych zapisanych w języku polskim. Model binarnej klasyfikacji miał na celu określenie czy dany fragment wzorca umownego jest postanowieniem abuzywnym (niedozwolonym postanowieniem umownym), czy też jest poprawnym (dozwolonym) zapisem w umowie konsumenckiej. W ramach pracy nad tym rozwiązaniem przetestowaliśmy wiele różnych podejść – od klasycznych (sieci bayesowskie, maszyna wektorów nośnych) po nowoczesne (głębokie sieci neuronowe). Różnice były drastyczne, najlepsza klasyczna metoda (maszyna wektorów nośnych) osiągała maksymalnie efektywność na poziomie 79%, gdy sieci typu Transformer (dokładniej model Polish RoBERTa) przebijały aż 90%. Rewolucja w NLP zaczęła w tym momencie pracować dla konkretnych wyzwań, w tym przypadku dla detekcji abuzywności w umowach.

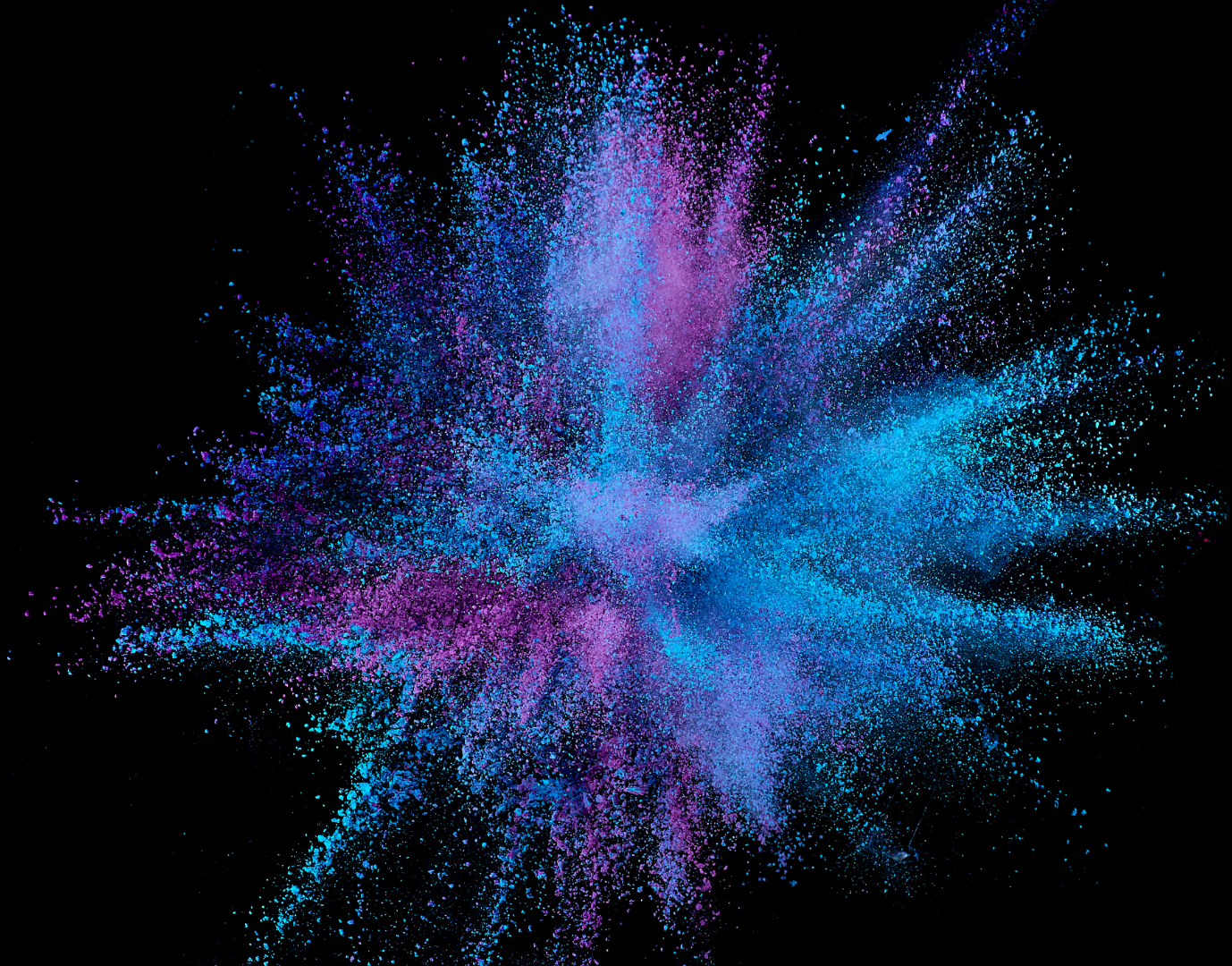

Nie lubimy nieliniowości, wręcz się jej boimy, ale prawdziwe rewolucje cywilizacyjne nie następują liniowo.

Rewolucje cywilizacyjne nie następują liniowo

Spoglądając wstecz o 10 lat (od pojawienia się word2veca w 2013 po dzień obecny), wiem, że doświadczyłem tzw. nieliniowej erupcji rozwoju. Jako informatycy i matematycy nie lubimy nieliniowości, wręcz się jej boimy. Pragniemy każdy problem zlinearyzować, aby mieć poczucie, że nad nim „panujemy”. Natomiast patrząc na historie ludzkości widzimy, że prawdziwe rewolucje cywilizacyjne nie następują liniowo. Są one wręcz pewnymi wybuchami, które przesuwają nas jako cywilizację niczym winda na kolejne piętra budynku bez pokonywania pojedynczych schodów. Aktualnie żyjemy w dekadzie erupcji rozwoju. ChatGPT jest tylko manifestacją tego zjawiska. Wręcz czerpie z niesamowitości rozwoju NLP jaki nastąpił od 2013 do teraz. Narzędzie to jest sygnałem cywilizacyjnym, iż zaczyna się właśnie upowszechnienie metod AI w życiu codziennym i jego wszelakich gospodarczych aspektach.